Negli ultimi due anni, i progressi nel campo dell’intelligenza artificiale, in particolare in un campo noto come “AI generativa”, sono stati rapidi. Demo di chatbot che scrivono come persone reali, algoritmi di generazione di immagini e generatori di parlato realistici sono diventati tutti comuni e accessibili alla persona media.

Questa espansione è stata in parte alimentata dall’ascesa dei grandi Foundation Models (FM): grandi sistemi di intelligenza artificiale addestrati su un enorme set di dati. Questi modelli di solito hanno milioni o miliardi di parametri e sono stati addestrati estraendo dati grezzi dall’Internet pubblica. Questi modelli tendono ad avere quello che viene chiamato comportamento emergente, ovvero la capacità di eseguire compiti al di fuori di ciò su cui sono stati direttamente addestrati. Per questo motivo, possono essere adattati a una varietà di applicazioni, fungendo da base per altri algoritmi.

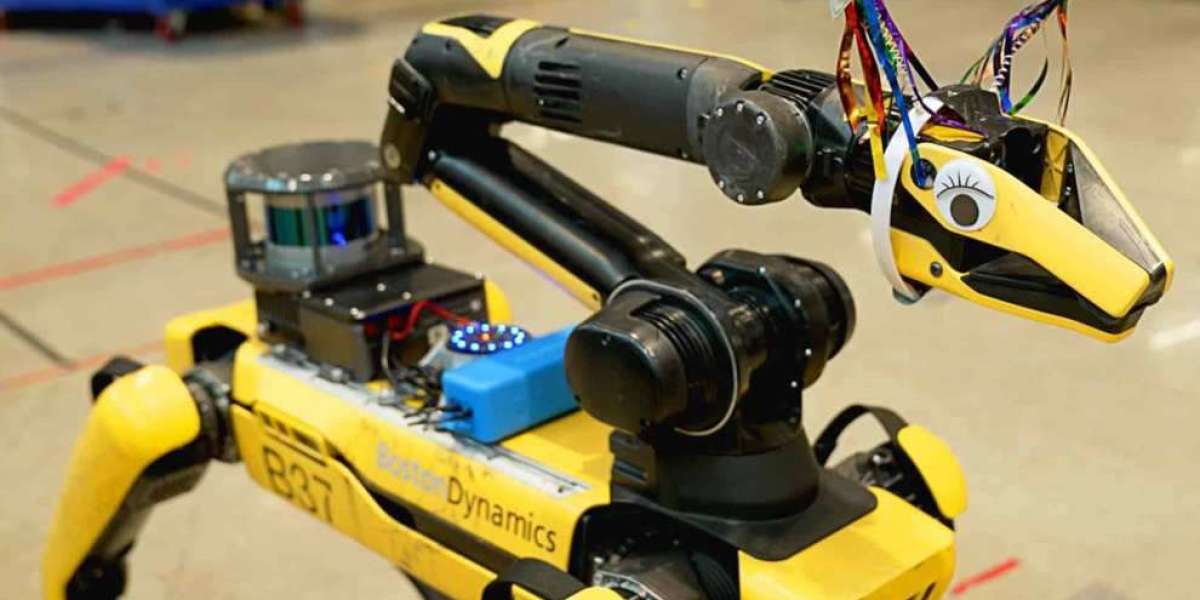

Il team di Boston Dynamics era interessato alla capacità degli LLM di interpretare ruoli, replicare cultura e sfumature, elaborare piani e mantenere la coerenza nel tempo. Il team si è anche ispirato ai modelli VQA (Visual Question Answering) recentemente rilasciati che possono didascalia delle immagini e rispondere a semplici domande su di esse.

Una guida turistica robotica sembrava la demo perfetta per testare questi concetti. Il robot camminerebbe, guarderebbe gli oggetti nell'ambiente e quindi utilizzerebbe un modello VQA o didascalia per descriverli. Il robot utilizzerebbe anche un LLM per elaborare queste descrizioni, rispondere alle domande del pubblico del tour e pianificare le azioni successive.

La demo pianificata dal team richiedeva che Spot fosse in grado di parlare a un gruppo e ascoltare le loro domande e suggerimenti. Boston Dynamics ha stampato in 3D un supporto resistente alle vibrazioni per un altoparlante Respeaker V2. Lo hanno collegato al payload EAP 2 di Spot utilizzando una USB.

Spot è controllato utilizzando un computer esterno, un PC desktop o un laptop, che utilizza l'SDK di Spot per comunicare. Il team ha aggiunto un semplice servizio Spot SDK per comunicare l'audio con il payload EAP 2.

Il team di Boston Dynamics ha inoltre concesso al LLM l'accesso al suo SDK, una mappa del sito del tour con descrizioni di una riga di ogni luogo e la possibilità di pronunciare frasi o porre domande. Lo hanno fatto integrando una VQA e un software di sintesi vocale.

Hanno inserito la fotocamera della pinza del robot e la fotocamera del corpo anteriore in BLIP-2 e l'hanno eseguito in modalità di risposta visiva alle domande o in modalità didascalia delle immagini. Viene eseguito circa una volta al secondo e i risultati vengono inseriti direttamente nel prompt.

Per dare a Spot la capacità di ascoltare, il team ha alimentato i dati del microfono in blocchi al sussurro di OpenAI per convertirli in testo inglese. Spot attende una parola di sveglia, come "Ehi, Spot" prima di inserire quel testo nel prompt e sopprime l'audio quando parla da solo.

Il team voleva anche che Spot avesse un linguaggio del corpo dall'aspetto più naturale. Quindi hanno utilizzato una funzionalità nell'aggiornamento Spot 3.3 che consente al robot di rilevare e tracciare oggetti in movimento per indovinare dove si trovava la persona più vicina, quindi hanno fatto girare il braccio al robot verso quella persona.

Utilizzando un filtro passa-basso sul parlato generato, il team è riuscito a far sì che la pinza imitasse il parlato, un po' come la bocca di un burattino. Questa illusione è stata rafforzata quando la squadra ha aggiunto costumi o occhi finti alla pinza.

Con questo progetto, Boston Dynamics ha trovato un modo per combinare insieme i risultati di diversi sistemi di intelligenza artificiale generali e generare risultati entusiasmanti su un robot reale utilizzando l'SDK di Spot. Guardando al futuro, il team prevede di continuare a esplorare l’intersezione tra intelligenza artificiale e robotica.