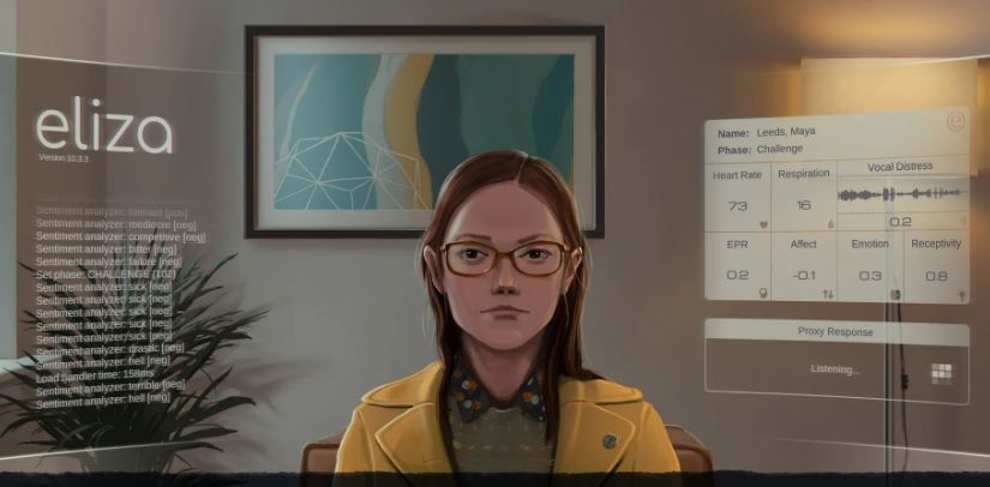

L'effetto Eliza si verifica quando qualcuno attribuisce erroneamente i processi mentali e le emozioni umane a un sistema di intelligenza artificiale, sovrastimando così l'intelligenza complessiva del sistema. Se hai mai avuto la sensazione che il tuo Assistente Google avesse una propria personalità o hai mai provato un senso di affinità mentre conversavi con ChatGPT, probabilmente ti sei innamorato dell'effetto Eliza.

"È essenzialmente un'illusione che una macchina con cui stai parlando abbia una comprensione del mondo più ampia, simile a quella umana", ha detto a Built In Margaret Mitchell, ricercatrice e scienziata capo dell'etica presso la società di intelligenza artificiale Hugging Face. "È avere la sensazione che ci sia una mente e un'intenzionalità enormi dietro un sistema che potrebbe non esistere in realtà."

Il fenomeno prende il nome da ELIZA, un chatbot creato nel 1966 dal professore del MIT Joseph Weizenbaum.

ELIZA ha avuto un effetto profondo e duraturo: sull'uomo che l'ha creato, sui suoi utenti e sul campo in cui esiste. Ora, più di mezzo secolo dopo, l’effetto Eliza continua a riecheggiare in tutto il settore dell’intelligenza artificiale.

Poiché i sottocampi dell’intelligenza artificiale come l’apprendimento automatico e il deep learning hanno continuato ad avanzare insieme alla crescita di Internet (e delle montagne di dati che produce), i computer sono ora abbastanza flessibili da apprendere – e persino generare – il linguaggio naturale da soli. Analizzando la vasta gamma di lingue online utilizzando una rete neurale , un moderno modello di intelligenza artificiale può apprendere molto più velocemente di quanto farebbe semplicemente essendo programmato un passo alla volta, come ai tempi di Weizenbaum.

Esempi dell'effetto ELIZA:

- Attribuzione di tratti umani come genere e personalità agli assistenti vocali AI

- Credere che un chatbot testuale provi emozioni reali e umane

- Innamorarsi dei chatbot testuali

- Sentirsi giudicati o insultati da un chatbot basato su testo

Ultimamente, ciò ha portato a progressi impressionanti nell’intelligenza artificiale conversazionale . Sebbene tecnicamente non comprendano ancora il linguaggio e i concetti nello stesso modo in cui possono farlo gli esseri umani, queste macchine sono diventate più convincenti come quelle umane, il che a sua volta ha complicato il modo in cui noi umani interagiamo con loro e le percepiamo.

Nel frattempo, la crescente sofisticazione dei chatbot testuali ha alimentato un’enorme quantità di discorsi riguardanti non solo il livello di intelligenza di questa tecnologia, ma la sua stessa sensibilità. Forse il più famoso è l'incidente con Blake Lemoine, un ex ingegnere di intelligenza artificiale di Google che dichiarò pubblicamente che uno dei più grandi modelli linguistici dell'azienda, LaMDA, aveva preso vita. E le interazioni con Replika, un chatbot pubblicizzato come "il migliore amico dell'intelligenza artificiale del mondo", sono state così realistiche che gli utenti comuni hanno riferito di essersene innamorati.

Anche Internet continua a essere inondato di conversazioni con ChatGPT e la nuova funzionalità di chat di Bing , alcune delle quali sono così realisticamente umane che gli utenti si chiedono se il modello abbia raggiunto un certo livello di consapevolezza. Kevin Roose, editorialista tecnologico del New York Times, ha descritto una conversazione di due ore che ha avuto con Bing nel 2023 che lo ha lasciato così turbato da avere problemi a dormire in seguito, sostenendo che a un certo punto ha persino dichiarato il suo amore per lui. Altri hanno riferito che il chatbot li ha offesi e insultati durante le discussioni.

A dire il vero, OpenAI è sempre stato abbastanza chiaro sul fatto che ChatGPT è un chatbot, e il fatto che sia semplicemente un motore di previsione della parola successiva altamente sofisticato è stato ampiamente pubblicizzato. Tuttavia, quando una persona interagisce con ChatGPT, non è raro che abbia la sensazione di chattare con un altro essere umano.

“La gente pensa ai computer come a esseri super intelligenti. Sono più intelligenti di noi, conoscono molti più fatti di noi e dovremmo avere fiducia che prendano decisioni per noi. Ma sono solo cercatori di modelli”, ha detto Smith, l'autore. Predicono semplicemente le prossime parole da dire. "Non hanno buon senso, non hanno capacità di pensiero critico, non hanno saggezza."

Poiché l’adozione dell’intelligenza artificiale conversazionale in aree come il servizio clienti , il marketing e altro ancora continua a crescere, probabilmente diventerà più difficile discernere se l’entità dall’altra parte di uno scambio di testo è un essere umano o meno. E i sentimenti riportati da Lemione, Roose e altri diventeranno probabilmente ancora più comuni man mano che sul mercato entreranno chatbot più sofisticati.

Sebbene l’effetto Eliza consenta alle persone di interagire con la tecnologia in modo più sfumato, questo fenomeno comporta alcune conseguenze negative. Innanzitutto, la sopravvalutazione dell’intelligenza di un sistema di intelligenza artificiale può portare a un livello eccessivo di fiducia, il che può essere piuttosto pericoloso quando il sistema sbaglia.

Infatti, ChatGPT e altri sofisticati chatbot diffondono regolarmente informazioni false. Ma quell'informazione è racchiusa in un'affermazione così eloquente e grammaticalmente corretta che è facile accettarla come verità. Gli esperti chiamano questi casi “allucinazioni ” e possono rappresentare un grosso problema quando un utente attribuisce già al sistema un elevato livello di intelligenza e comprensione del mondo reale.

Ma al di là della semplice allucinazione e disinformazione, l’effetto Eliza può anche essere un mezzo di persuasione molto potente. Se qualcuno attribuisce una quantità smisurata di intelligenza e fattualità a un particolare chatbot, ad esempio, è più probabile che venga convinto dalle sue parole. Questo può essere uno strumento piuttosto potente, a seconda di quale persona, azienda o persino governo ha il controllo di quel chatbot.

È un modo per manipolare le persone in modo molto efficace. E poi collegando questo al modo in cui le conversazioni potrebbero essere tracciate e alle diverse informazioni che possono essere raccolte su una persona, ora si tratta di manipolazione informata da, potenzialmente, informazioni personali su qualcuno. Quindi è ancora più efficace.

Prevenire ciò potrebbe non essere facile, soprattutto perché i sistemi di intelligenza artificiale continuano a diventare sempre più sofisticati. Le capacità di conversazione dell'intelligenza artificiale stanno solo migliorando, il che significa che è improbabile che l'effetto Eliza scompaia tanto presto. Pertanto, spetta a tutti noi continuare a crescere e ad adattarci di pari passo con la tecnologia, ha affermato Allen, professore dell'Università di Pittsburgh.

La cosa più importante è ricordare sempre che l’intelligenza artificiale non ha emozioni, ma può imitare le risposte empatiche umane per creare un falso senso di emozione.