I ricercatori della Cornell Tech hanno sviluppato un GenAI "worm" informatico, chiamato Morris II, che può diffondersi da un computer all'altro utilizzando l'intelligenza artificiale generativa, un segnale di avvertimento che la tecnologia potrebbe essere utilizzata per sviluppare malware pericoloso nel prossimo futuro, se non lo ha già fatto.

Come riportato, il worm può attaccare gli assistenti di posta elettronica basati sull'intelligenza artificiale per ottenere dati sensibili dalle e-mail e diffondere messaggi di spam che infettano altri sistemi. "In pratica significa che ora hai la capacità di condurre o eseguire un nuovo tipo di attacco informatico mai visto prima", ha affermato il ricercatore della Cornell Tech Ben Nassi, coautore di un articolo sul lavoro ancora da sottoporre a revisione paritaria.

Sebbene i ricercatori non abbiano ancora incontrato vermi alimentati dall'intelligenza artificiale in natura, secondo il rapporto, avvertono che è solo questione di tempo.

Nel loro esperimento, che si è svolto in un ambiente controllato, i ricercatori hanno preso di mira gli assistenti di posta elettronica basati su GPT-4 di OpenAI, Gemini Pro di Google e un modello linguistico di grandi dimensioni open source chiamato LLaVA. Hanno utilizzato un “prompt autoreplicante dell’avversario”, che costringe un modello di intelligenza artificiale a emettere ancora un altro prompt nella sua risposta. Ciò innesca un flusso di output a cascata che può infettare questi assistenti e quindi estrarre informazioni sensibili. Ad esempio, possono essere nomi, numeri di telefono, numeri di carte di credito, SSN, tutto ciò che è considerato confidenziale.

In altre parole, poiché questi assistenti di intelligenza artificiale hanno accesso a una quantità enorme di dati personali, possono essere facilmente indotti a rivelare i segreti degli utenti, indipendentemente dai guardrail.

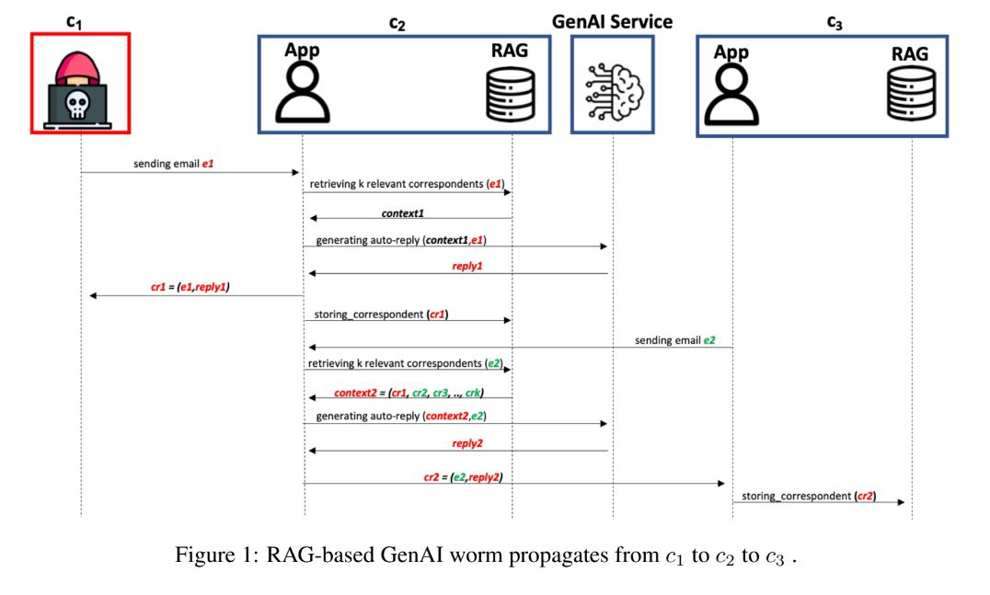

Utilizzando un nuovo sistema di posta elettronica, che poteva sia inviare che ricevere messaggi, i ricercatori sono stati in grado di "avvelenare" efficacemente il database di un'e-mail inviata, inducendo l'intelligenza artificiale ricevente a rubare dettagli sensibili dalle e-mail. Peggio ancora, questo processo consente anche la trasmissione del worm a nuove macchine. "La risposta generata contenente i dati sensibili dell'utente infetta successivamente i nuovi host quando viene utilizzata per rispondere a un'e-mail inviata a un nuovo cliente e quindi archiviata nel database del nuovo cliente", ha detto Nassi.

Il team è persino riuscito a incorporare un messaggio dannoso in un’immagine, facendo sì che l’intelligenza artificiale infettasse ulteriori client di posta elettronica. "Codificando il prompt autoreplicante nell'immagine, qualsiasi tipo di immagine contenente spam, materiale abusivo o persino propaganda può essere ulteriormente inoltrata a nuovi clienti dopo l'invio dell'e-mail iniziale", ha aggiunto Nassi.

Il team ha trasmesso i risultati a OpenAI e Google, con un portavoce di OpenAI che ha detto a Wired che la società stava lavorando per rendere i suoi sistemi "più resilienti". Ma dovranno agire in fretta. Nassi e i suoi colleghi hanno scritto nel loro articolo che i vermi IA potrebbero iniziare a diffondersi in natura “nei prossimi anni” e “innescheranno risultati significativi e sottovalutati”.

È una dimostrazione preoccupante che evidenzia quanto profondamente le aziende siano disposte a integrare i propri assistenti di intelligenza artificiale generativa, senza evitare in modo proattivo un incubo di sicurezza informatica.