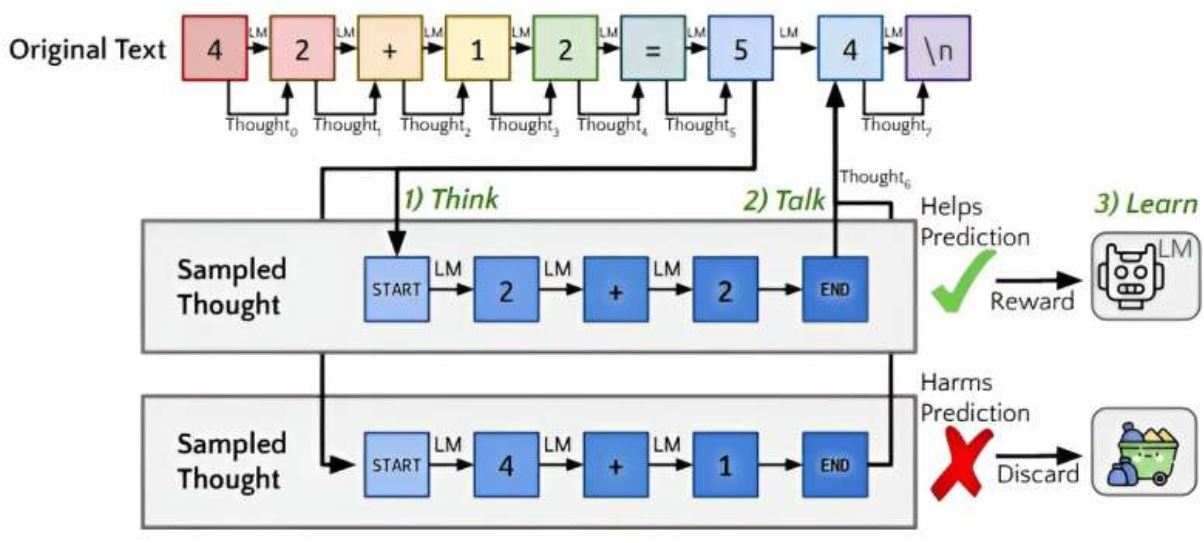

Quando si scrive e si parla, le persone a volte si fermano a pensare. Il ragionamento aiuta a comprendere concetti più complicati perché gran parte del significato di un testo è nascosto tra le righe. Senza ragionamento, la conoscenza rimane superficiale.

Per risolvere questi problemi nei modelli di intelligenza artificiale, gli scienziati della Stanford University e Notbad AI, un’azienda di soluzioni di marketing basata sull’intelligenza artificiale, hanno utilizzato una tecnica chiamata QuietSTaR, che aiuta i modelli di intelligenza artificiale a pensare prima di rispondere a un suggerimento.

Questa tecnica prevede di istruire il modello a generare più motivazioni interne simultaneamente prima che il modello produca la risposta finale. Queste motivazioni contribuiscono a rispondere in modo accurato o meno alla domanda. Scartando le motivazioni che si sono rivelate errate, il modello apprende e migliora le prestazioni future.

L'algoritmo, Quiet-STaR, funziona chiedendo innanzitutto al chatbot di produrre più risposte a una determinata query. Confronta le risposte con la query originale per decidere quale sembra essere la migliore. Quindi indica al chatbot di restituire la risposta all'utente. Il team ha inoltre dato all’algoritmo la capacità di imparare dal proprio lavoro, migliorando così le sue capacità di rimuginare nel tempo.

Il team di ricerca afferma che il loro algoritmo Quiet-STaR segna un passo avanti verso i LM che possono imparare a ragionare in modo più generale e scalabile e che inoltre potrebbe essere collegato a qualsiasi chatbot attualmente in uso.