Varie unità militari in tutto il mondo (in particolare nel Regno Unito durante la pandemia) sono state coinvolte in ciò che, a causa dell’obiettivo (censura) e dei partecipanti (militari), sono destinati a diventare sforzi controversi, se non illegali.

Ma non sembra esserci molta voglia di imparare dagli errori degli altri. La tentazione di portare il sistema di difesa nell’arena politica della “guerra alla disinformazione” sembra essere troppo forte per resistere.

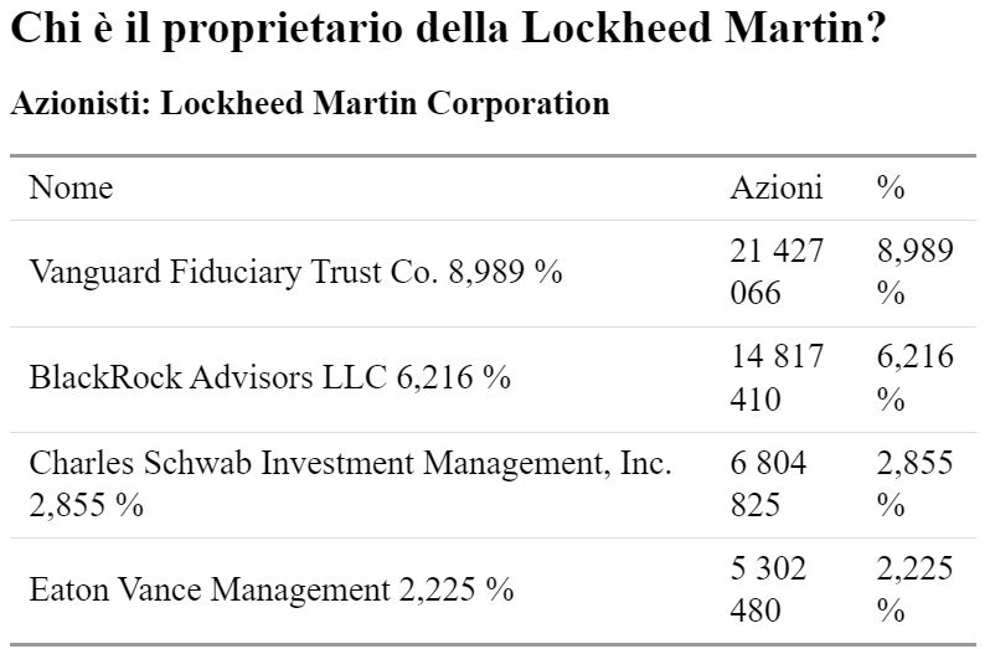

Proprio adesso negli Stati Uniti, Lockheed Martin è vicino al completamento di un prototipo che analizzerà i media per “rilevare e sconfiggere la disinformazione”.

E per media, coloro che hanno commissionato lo strumento – chiamato programma Semantic Forensics (SemaFor) – intendono tutto: notizie, Internet e persino media di intrattenimento. Testo, audio, immagini e video che fanno parte di quelli che sono considerati “attacchi di disinformazione automatizzati su larga scala” dovrebbero essere rilevati ed etichettati come falsi dallo strumento.

Il processo di sviluppo è quasi terminato e il prototipo è utilizzato dalla Defense Advanced Research Projects Agency (DARPA) del Dipartimento della Difesa degli Stati Uniti.

Il valore totale del programma, assegnato dalla Direzione delle informazioni del Laboratorio di ricerca dell’aeronautica militare (che agisce per conto della DARPA) alla Lockheed Martin ammonta a 37,2 milioni di dollari, ha riferito l’elettronica militare e aerospaziale.

I rapporti rilevano che, sebbene i metodi di rilevamento statistico del passato abbiano avuto “successo”, ora sono considerati “insufficienti” per il rilevamento della disinformazione mediatica. Questo è il motivo per cui è preferibile esaminare l’“incoerenza semantica”.

Viene fornito un esempio piuttosto curioso di come gli “orecchini non corrispondenti” possano essere un indizio del fatto che un volto non è reale ma generato tramite un GAN – una rete generativa avversaria. (I GAN sono un metodo di apprendimento automatico.)

E lo scopo di SemaFor è quello di analizzare i media con algoritmi tecnologici semantici, per emettere il verdetto se il contenuto è autentico o falso.

C’è di più: dimostrare che tali attività provengono da un attore specifico è stato finora quasi impossibile, ma esiste una “soluzione mentale” di cui coloro che stanno dietro al progetto sembrano soddisfatti: dedurre, piuttosto che identificare. Quindi, proprio come prima?

Gli “algoritmi di attribuzione” sono ciò che serve per questo, e ci sono altre congetture presentate come tecnologia affidabile – vale a dire, “algoritmi di caratterizzazione” per decidere non solo se i media vengono manipolati o generati, ma anche se lo scopo è dannoso.

Ora resta solo da scoprire come sono scritti gli algoritmi.